Cảnh báo rủi ro khôn lường cho những ai hay bàn chuyện công việc qua điện thoại: Đừng để tiền rơi!

Đã là nhân viên thì không thể không nghe điện thoại của sếp nhưng hành động này lại có thể khiến bạn gặp nguy.

Cùng sự phát triển của công nghệ, tội phạm mạng đang không ngừng tìm kiếm những cách mới để lừa đảo. Một trong những công nghệ mới được nhóm này sử dụng là phần mềm mô phỏng giọng nói.

Ví dụ, CEO của một công ty cung cấp năng lượng ở Anh từng chuyển 249.000 USD cho một kẻ lừa đảo trực tuyến sau khi nhận cuộc gọi của một người dường như là nhân vật đứng đầu công ty mẹ (ở Đức) của nơi ông đang làm việc.

Theo đó, CEO này được yêu cầu chuyển tiền cho một nhà cung cấp tại Hungary. Không hề nghi ngờ giọng nói ở đầu dây bên kia, ông đã mắc bẫy của kẻ lừa đảo và mất tiền.

Giọng nói được tạo ra bằng AI có thể được dùng để lừa đảo (Ảnh: Tech Xplore).

Rudiger Kirsch, một chuyên gia về gian lận cho biết giọng nói đó thực chất được tạo ra bằng trí tuệ nhân tạo (AI). Từ lâu, các chuyên gia an ninh mạng đã lo ngại về những gì hacker có thể làm với AI, chẳng hạn như tạo ra đoạn video trong đó giám đốc công ty muốn biết mật khẩu của bạn.

Phần mềm AI hiện có khả năng thực hiện việc này trong thời gian thực, nghĩa là hacker hoàn toàn có thể giả làm sếp của bạn trong cuộc gọi Zoom.

Ngày 17/8 vừa qua, các nhà nghiên cứu tại công ty an ninh mạng Mandiant thuộc sở hữu của Google đã ghi nhận một số trường hợp đầu tiên về công nghệ video deepfake (gán khuôn mặt của người này sang người khác trong video) được thiết kế và bán cho những kẻ lừa đảo.

Quảng cáo trên các diễn đàn hacker và kênh Telegram cho thấy giá thành của dịch vụ này chỉ khoảng 20 USD cho mỗi phút của video, 250 USD cho một video đầy đủ hoặc 200 USD cho một buổi hướng dẫn.

Luke McNamara, nhà phân tích chính tại Mandiant cho biết, các nhà nghiên cứu không thể xác nhận rằng dịch vụ mà họ xác định được trên các diễn đàn hacker là hợp pháp hay liệu deepfake có được sử dụng trong bất kỳ vụ lừa đảo nào hay không, nhưng mối đe dọa của công nghệ này là có thật.

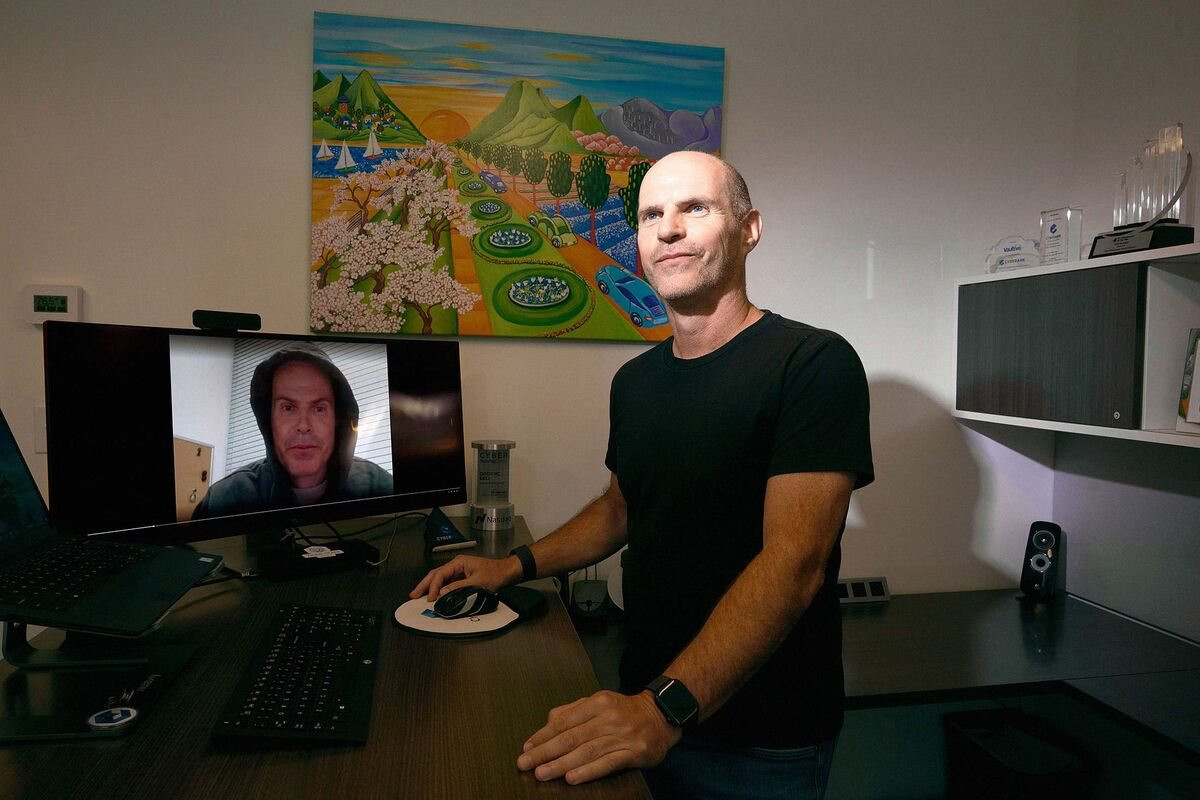

Gần đây, Udi Mokady - chủ tịch công ty bảo mật thông tin CyberArk Software đã có trải nghiệm chân thực với kiểu tấn công trên. Trong một cuộc họp trực tuyến qua Microsoft Teams, ông đã đối mặt với bản deepfake của chính mình. “Tôi đã bị sốc khi thấy mình ở phía bên kia với phông nền là văn phòng của tôi”, Mokady chia sẻ.

Udi Mokady và video deepfake giả mạo chính mình (Ảnh: Bloomberg).

Việc này được thực hiện bởi Gal Zror, một trong những nhân viên của Mokady. Zror đã sử dụng các công cụ AI tổng hợp miễn phí để tạo lại hình ảnh của Mokady nhằm mục đích cảnh báo cho cấp trên về sự nguy hiểm của công nghệ deepfake.

“Vì mọi người đều đã quen với chất lượng âm thanh và video không quá tốt trong các cuộc gọi trực tuyến nên đoạn video deepfake dù chưa hoàn hảo nhưng vẫn đủ để đánh lừa. Tôi mất vài ngày để hoàn thành dự án trên và một người không am hiểu kỹ thuật nhưng có khả năng tính toán tốt có thể thực hiện việc đó trong vòng vài tuần”, Zror cho biết thêm.

Mokady cho rằng nhân viên của công ty (đều am hiểu công nghệ) có thể phát hiện đoạn video của Zror là giả nhưng những người bình thường chưa chắc có thể nhận ra sự khác biệt.

Các chuyên gia bảo mật cảnh báo rằng những kẻ lừa đảo đang lợi dụng sự phát triển của công nghệ, đặc biệt là AI để nghĩ ra nhiều chiêu thức lừa tiền của mọi người. Vì vậy, với bất kỳ yêu cầu chuyển tiền hay tiết lộ mật khẩu nào, bạn cũng nên cẩn trọng và xác minh cẩn thận để tránh rơi vào bẫy lừa đảo.

Nhịp sống thị trường