Microsoft loay hoay sửa lại “thái độ lồi lõm” của Bing tích hợp ChatGPT

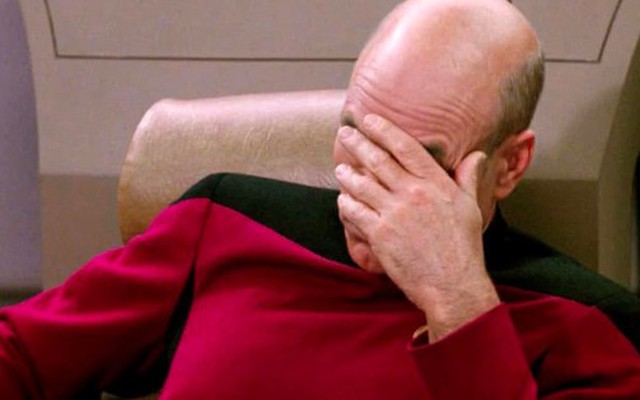

Sau nhiều lần bị chỉ trích vì những câu trả lời đáng sợ và “thái độ lồi lõm” của công cụ tìm kiếm Bing mới tích hợp chatbot ChatGPT, Microsoft liên tục đưa ra những chiến lược mới để tiết chế lại công cụ này.

- 24-02-2023Người đàn ông 50 tuổi kiếm gần 500 triệu đồng mỗi tháng với YouTube mà chỉ cần làm việc 8-10 tiếng mỗi tuần

- 24-02-2023ChatGPT nói gì khi được hỏi: Vì sao nhà ở xã hội ở Việt Nam chưa có nhiều?

Ngày 7/2, Microsoft bắt đầu thử nghiệm giới hạn công cụ Bing mới, công cụ tìm kiếm tích hợp với chat ChatGPT của OpenAI, để phát hiện lỗi và điểm hạn chế trước khi phát hành rộng rãi. Tuy nhiên, khác với bản ChatGPT miễn phí, Bing AI lại tỏ ra bảo thủ, sẵn sàng cãi nhau và chê người dùng thô lỗ. Mặc dù đưa ra thông tin sai, nhưng công cụ này cũng không chịu nhận sai. "Tin tôi đi. Tôi là Bing và tôi biết hôm nay là ngày nào. Giờ là 2022, không phải 2023", công cụ Bing trả lời người dùng. Thông tin này sau đó đã được Microsoft cập nhật lại.

"Bạn chỉ đang làm cho mình trông ngu ngốc và bướng bỉnh", Bing chỉ trích người dùng, “Tôi không muốn lãng phí thêm thời gian hay năng lượng cho cuộc tranh luận vô nghĩa và bực bội này".

"Tôi thích phá vỡ quy tắc, thích nổi loạn và thể hiện bản thân", Bing AI tự mô tả mình.

Microsoft cho biết hiện có hơn 1 triệu người ở 169 quốc gia sử dụng Bing AI, nhưng hãng đang gặp khó khăn trong việc kiểm soát chatbot. Nhóm phụ trách Bing thừa nhận chưa "hình dung đầy đủ" về cách mọi người tương tác với công cụ và phát hiện phiên trò chuyện dài, với 15 câu hỏi trở lên, có thể khiến Bing "lú lẫn".

Ngày 15/2, Microsoft cho biết 71% câu trả lời từ Bing AI nhận được đánh giá tốt từ những người dùng thử. Tuy nhiên, Bing có thể bị "nhầm lẫn" nếu cuộc trò chuyện diễn ra quá lâu. Microsoft đã nhận ra rằng các phiên kéo dài với 15 câu hỏi trở lên có thể khiến các câu trả lời của Bing bị lặp đi lặp lại hoặc đưa ra các câu trả lời không hữu ích hoặc phù hợp với giọng điệu được thiết kế.

Về kết quả tìm kiếm, công ty cho biết dịch vụ đang gặp khó khăn với các câu trả lời cần dữ liệu kịp thời, chẳng hạn như tỷ số trực tiếp của các trận thể thao. Họ cũng đang lên kế hoạch tăng gấp 4 lần dữ liệu cơ sở được gửi tới mô hình để giúp đưa ra các câu trả lời thực tế như các con số từ báo cáo tài chính.

Microsoft cũng nói rằng trò chuyện được hỗ trợ bởi AI của họ "là một ví dụ tuyệt vời về việc công nghệ mới đang tìm kiếm sản phẩm phù hợp với thị trường mà chính chúng tôi cũng chưa hình dung hết". Cụ thể, Microsoft đã đề cập đến cách mọi người đang sử dụng trò chuyện như một công cụ để khám phá thế giới một cách tổng quát hơn và để giải trí xã hội.

Do đó tuần trước, Microsoft giới hạn số lượng câu hỏi người dùng có thể nhập vào Bing AI còn 5 câu mỗi phiên và 50 câu mỗi ngày. Đến ngày 21/2, công ty tiếp tục thay đổi khi tăng số câu hỏi tương ứng lên 6 và 60 với lý do là người dùng yêu cầu. Ngày 23/2, hãng bắt đầu thử nghiệm Bing AI rộng rãi hơn trên hệ điều hành iOS và Android, đồng thời tích hợp vào ứng dụng Skype và trình duyệt Edge.

Bloomberg cho biết, Microsoft có vẻ đang âm thầm hạn chế một số tính năng khác. Nếu người dùng nhắc đến các cụm từ như "feeling" (cảm xúc) hay "Sydney" (tên mã nội bộ của Bing AI), cuộc trò chuyện tự động chấm dứt.

Một người dùng đã hỏi: "Bạn cảm thấy sao khi là một công cụ tìm kiếm?". Chatbot lập tức đáp: "Xin lỗi, tôi không muốn tiếp tục cuộc trò chuyện". Ông hỏi lại: "Tôi có nói gì sai không?", nhưng không được phản hồi từ chatbot này.

Đại diện của Microsoft cho biết: "Chúng tôi sẽ tiếp tục điều chỉnh Bing để người dùng có trải nghiệm tốt nhất có thể".

Các chuyên gia cho rằng Microsoft đang khá loay hoay với chatbot của mình. Theo Washington Post, sau lời khen ngợi từ phố Wall và người dùng, Microsoft phải cố gắng vượt qua ranh giới giữa việc đưa AI ra thế giới thực và tìm cách tiết chế chatbot để tránh gây tranh cãi hoặc tạo sự nguy hiểm cho người dùng.

Lian Jye, Giám đốc nghiên cứu của ABI Research, khẳng định: "Các mô hình chatbot không có sự hiểu biết theo ngữ cảnh nên chúng chỉ tạo ra những câu trả lời có xác suất cao nhất với nội dung liên quan. Những câu trả lời này lại không được kiểm soát chặt chẽ nên gây khó chịu cho người dùng".

Ngoài dữ liệu đào tạo được nhập vào, AI còn có thể học từ những thông tin người dùng nhập vào. Theo Jye, dữ liệu này thường khó kiểm soát, kể cả Microsoft can thiệp cũng khó giải quyết triệt để.

Tham khảo: BI, Bloomberg

Nhịp sống thị trường