Một sản phẩm 'tí hon' của NVIDIA chỉ tốn 79 triệu đồng để sản xuất, bán ra với giá gần 1 tỷ đồng

Mặc dù có giá bán đắt đỏ, mẫu GPU chuyên dụng này của Nvidia vẫn đang được hàng loạt ông lớn công nghệ săn lùng, giúp hãng này thu lợi lớn.

- 22-08-2023Dân số già, đất nghĩa trang lại đắt, Trung Quốc sáng tạo dịch vụ an táng số, đặt mục tiêu giảm 70% diện tích đất sử dụng của các nghĩa trang

- 22-08-2023Trẻ em sử dụng internet - lợi hay hại?

- 22-08-2023Thận trọng khi dùng ứng dụng AI chỉnh sửa ảnh

Nvidia đang thu về gần 1.000% tỷ lệ phần trăm lợi nhuận cho mỗi GPU chuyên dụng dành cho AI H100 mà hãng này bán ra. Đây là ước tính được đưa ra trong một bài đăng trên mạng xã hội gần đây từ Tae Kim - phóng viên kì cựu của trang tin tức tài chính và đầu tư nổi tiếng Barron.

Theo đó, nếu quy đổi ra số tiền cụ thể (USD), giá thị trường của mỗi chiếc H100 của Nvidia sẽ được bán với giá khoảng từ 25-30.000 USD cho tới 40.000 USD (tức khoảng 952 triệu đồng) gấp nhiều lần so với chi phí sản xuất ước tính của mẫu GPU này. Theo đó, H100 được cho là tốn khoảng 3320 USD/chiếc (tức khoảng 79 triệu đồng) để sản xuất, bao gồm các chi phí liên quan đến chip bộ nhớ HBM trên bo mạch.

Được biết, con số chi phí ước tính nói trên của chip H100 được phóng viên Tae Kim trích dẫn từ nguồn tin của công ty tư vấn tài chính Raymond James. Tuy nhiên, vẫn chưa rõ phân tích chi phí này chi tiết đến mức nào.

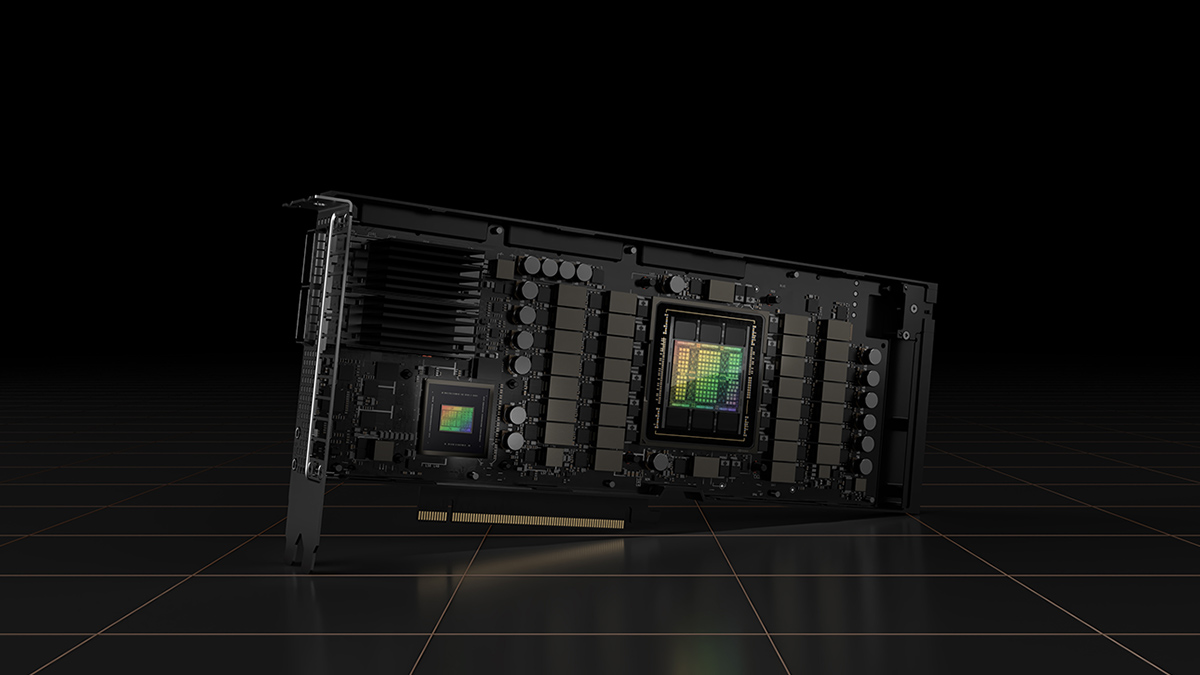

GPU chuyên dụng H100 của Nvidia. Ảnh: Internet

Nếu con số này chỉ là chi phí sản xuất thuần túy (tính trung bình giá trên mỗi tấm wafer và các thành phần khác, trong khi tính đến sản lượng), Nvidia vẫn phải trang trải một khoản chi phí đáng kể cho mỗi chiếc H100 được xuất xưởng và tới tay người dùng.

Về cơ bản, việc phát triển sản phẩm cần rất nhiều thời gian và nguồn lực. Chưa kể đến, các chi phí về R&D và chi phí nhân sự tham gia phát triển cho một sản phẩm như H100 cũng cần được tính đến trước khi tinh ra được chi phí phát triển sản phẩm trung bình cuối cùng.

Theo Glassdoor, mức lương trung bình tại Nvidia của một kỹ sư phần cứng điện tử vào khoảng 202.000 USD mỗi năm. Thông thường, quá trình phát triển các con chip như H100 cần hàng nghìn giờ từ một số lượng không nhỏ chuyên gia bậc cao. Tất cả điều đó cũng phải được tính đến.

Mặc dù vậy, không thể phủ nhận rằng Nvidia có những lợi thế khi trở thành cái tên mặc định cho các GPU chuyên dụng có khả năng xử lý các tác vụ AI. Theo nhiều nguồn tin khác nhau, GPU chuyên dụng của Nvidia bán chạy tới mức đơn đặt hàng đã được bán hết cho đến năm 2024.

Trong khi đó, các công ty AI đang cố gắng đảm bảo có đủ GPU để cung cấp năng lượng cho các mô hình sản xuất và tạo sinh do AI cung cấp. Foxconn dự đoán rằng thị trường máy chủ AI sẽ đạt giá trị 150 tỷ USD vào năm 2027 và những máy chủ AI hiện đại này phụ thuộc rất nhiều vào khả năng tính toán mạnh mẽ của phần cứng Nvidia mới nhất.

GPU H100 dựa trên vi kiến trúc Hopper, được thiết kế để sử dụng trong các trung tâm dữ liệu, đối trọng với kiến trúc Ada Lovelace hỗ trợ thế hệ GPU chơi game GeForce RTX mới nhất. Tuy nhiên, trọng tâm chính của Hopper không phải là chơi game. H100 được trang bị GPU GH100 đã được sửa đổi có 14.592 lõi CUDA, cùng 80GB RAM HBM3 với bus bộ nhớ 5.120 bit.

Tham khảo Tomshardware

Phụ nữ thủ đô