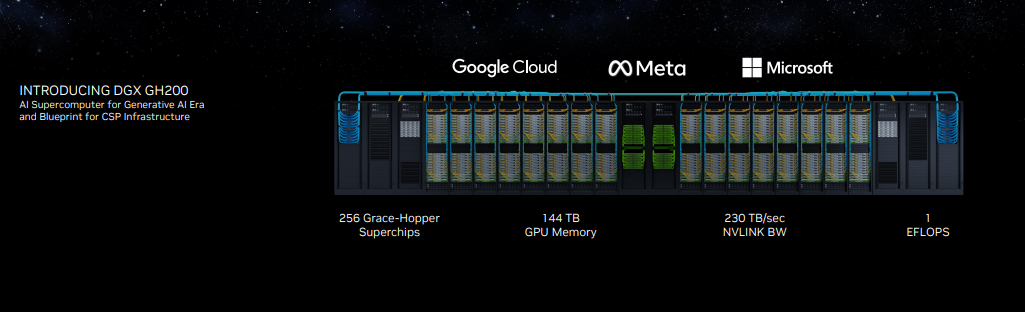

NVIDIA công bố DGX GH200, siêu máy tính AI hứa hẹn mở ra kỷ nguyên mới cho ChatGPT

Với khả năng kết nối 256 siêu chip xử lý Grace Hopper Superchips, bộ nhớ dùng chung 144TB, cao gấp 500 lần hệ thống DGX A100, vốn được dùng để huấn luyện ChatGPT.

- 31-05-2023Xử lý việc hoạt động thương mại điện tử không kê khai, nộp thuế

- 31-05-2023Chuyển đổi sử dụng mã định danh cá nhân làm mã số thuế

Khi cơn sốt AI vẫn đang chưa có dấu hiệu dừng lại, Nvidia – một trong những công ty được hưởng lợi nhiều nhất của cơn sốt này – đã tiếp tục ra mắt một sản phẩm mới để tận dụng tối đa cơ hội hiếm có này.

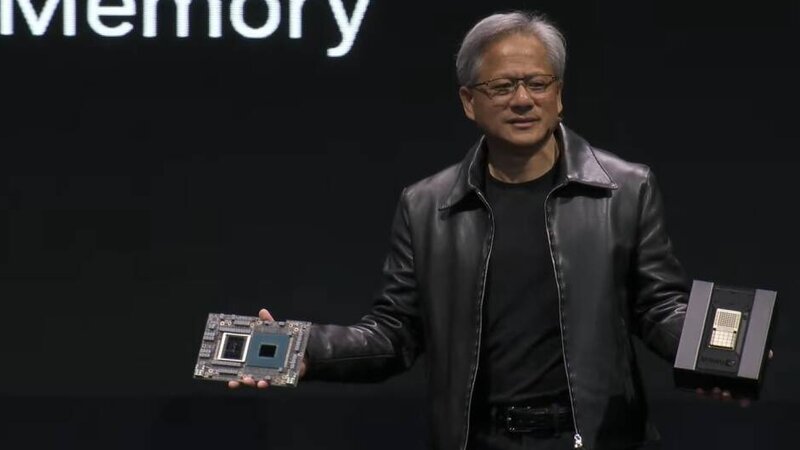

Trong sự kiện Computex 2023 đang diễn ra, CEO Nvidia, ông Jensen Huang đã giới thiệu một số sản phẩm và dịch vụ mới, hàng đầu trong số đó là nền tảng siêu máy tính DGX thế hệ tiếp theo có tên DGX GH200. Không gì lạ khi đây sẽ là sản phẩm nhằm vào cơn sốt AI vẫn đang diễn ra trên toàn cầu với khả năng giúp các công ty phát triển những mô hình AI sản sinh mạnh mẽ hơn.

Trong thông báo của mình, Nvidia cho biết, DGX GH200 – người kế nhiệm của dòng chip A100 hiện nay – sẽ giúp các khách hàng tạo ra nên câu chuyện thành công tương tự như ChatGPT. Google, Microsoft và Meta sẽ là những khách hàng lớn đầu tiên đối với dòng sản phẩm siêu máy tính này.

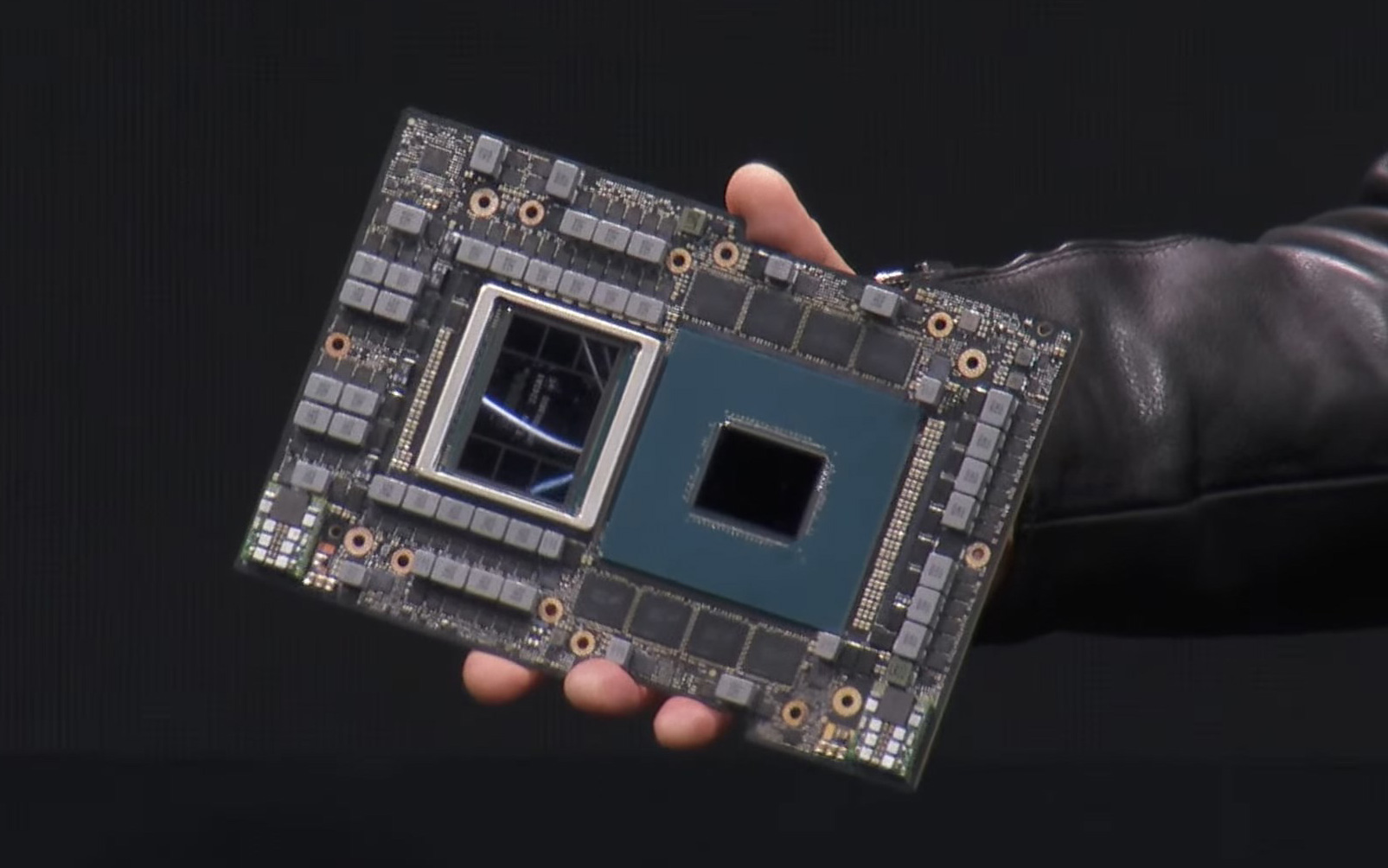

Nền tảng siêu điện toán AI này được tạo nên từ việc ghép nối 256 siêu chip Grace Hopper Superchips trên bộ nhớ dùng chung 144TB, cho phép xử lý được các tác vụ huấn luyện AI sản sinh tiêu tốn hiệu năng nhất hiện nay. Mỗi siêu chip Grace Hopper này là sự kết hợp giữa một CPU ARM 72 nhân Grace, một GPU Hopper và 96GB bộ nhớ HBM3 và 512GB bộ nhớ LPDDR5X trên cùng một chip với tổng cộng 200 tỷ bóng bán dẫn.

Siêu chip Grace Hopper

Để thấy được sức mạnh của nền tảng siêu điện toán AI mới này, hãy thử so sánh với hệ thống DGX A100, nền tảng điện toán AI đã giúp làm nên thành công cho ChatGPT của OpenAI. Hệ thống DGX A100 chỉ có thể kết nối 8 GPU A100 với nhau thành một bộ xử lý duy nhất có bộ nhớ dùng chung 320GB.

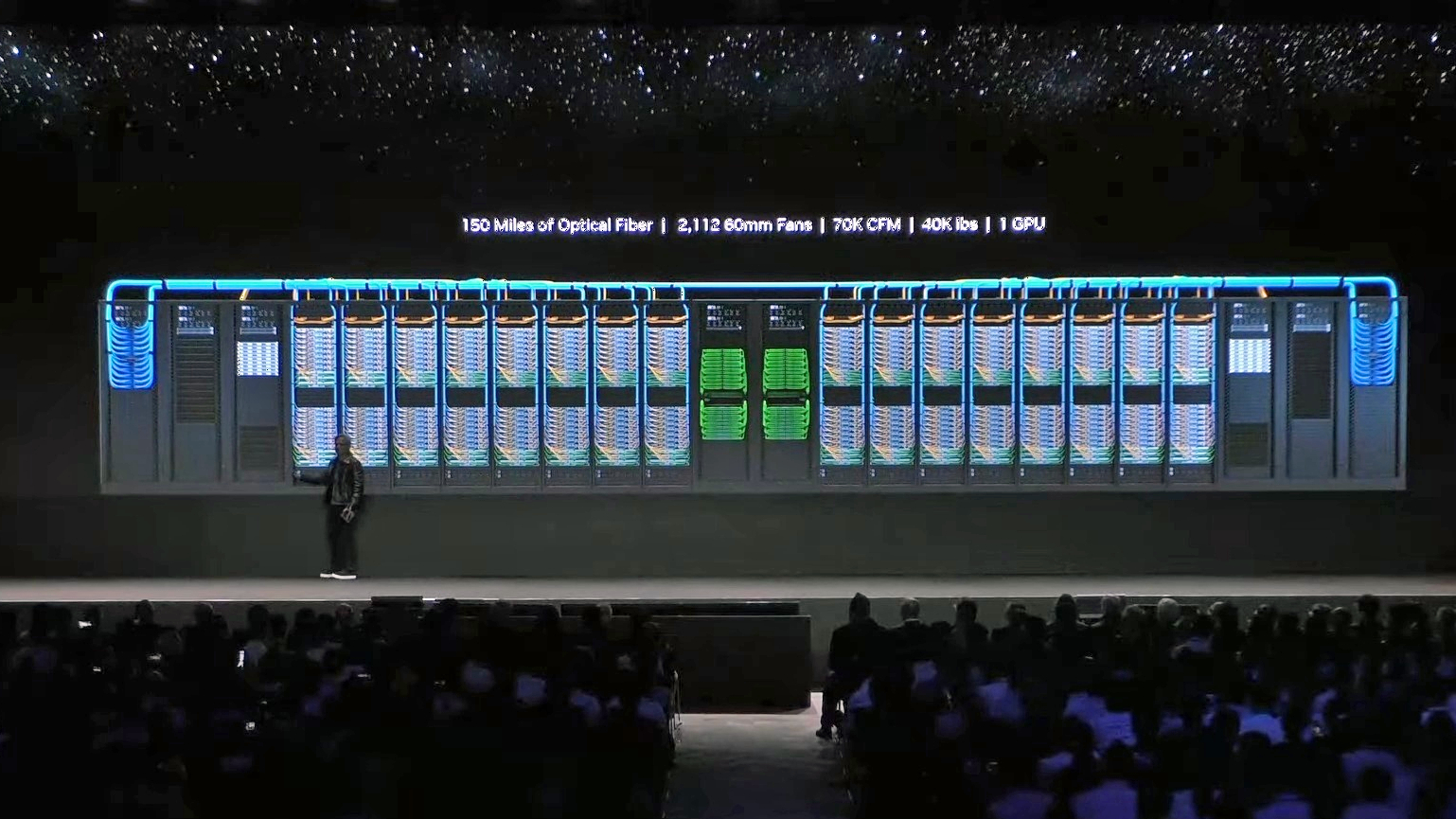

So với DGX A100, DGX GH200 mới ra mắt sử dụng hệ thống liên kết mới NVLink Switch System với 36 switch NVLink để liên kết 256 chip Grace Hopper – cho phép chúng hoạt động như một GPU khổng lồ có khả năng xử lý vượt trội – với bộ nhớ dùng chung 144TB, nhiều hơn 500 lần so với hệ thống DGX A100.

Đối với các tác vụ siêu nặng như huấn luyện hoặc xử lý các phép tính AI, khả năng liên kết các bộ xử lý với nhau thông qua các kết nối băng thông siêu lớn sẽ mang lại hiệu năng xử lý như một bộ xử lý duy nhất – lớn gấp nhiều lần so với một hệ thống siêu máy tính thông thường. Trước sự bùng nổ các công cụ AI sản sinh, khách hàng của Nvidia đang hối thúc công ty ra mắt các hệ thống có hiệu năng cao hơn nữa, thay vì chỉ giới hạn trong 8 GPU A100 như hiện tại và DGX GH200 nhằm đáp ứng yêu cầu như vậy.

Siêu máy tính DGX GH200 được tạo nên nhờ khả năng liên kết 256 bộ xử lý Grace Hopper.

Nvidia cho biết, DGX GH200 là lần đầu tiên toàn bộ một hệ thống siêu máy tính được công ty xây dựng xung quanh kiến trúc NVLink Switch, với băng thông liên kết GPU – GPU và GPU – CPU cao hơn đến 10 lần và 7 lần so với hệ thống tiền nhiệm. Toàn bộ hệ thống sử dụng đến 240 km cáp quang tốc độ cao, nặng hơn 18 tấn nhưng vận hành như một GPU duy nhất.

Nvidia cho biết hệ thống siêu máy tính này mang lại "hiệu năng AI" đến 1 exaflop – gần bằng siêu máy tính Frontier tại Phòng Thí nghiệm Quốc gia Oak Ridge ở Tennessee – hệ thống siêu máy tính duy nhất được công nhận có điểm số hiệu năng đạt tới gần 1,2 exaflop, cao gấp đôi so với hệ thống siêu máy tính ở vị trí thứ hai Fugaku của Nhật Bản.

Bên cạnh hệ thống siêu máy tính mới, Nvidia cũng giới thiệu kiến trúc tham chiếu MGX mới sẽ giúp các hãng OEM xây dựng các siêu máy tính AI mới nhanh hơn khi có thể kết nối đến 100 hệ thống hiện tại với nhau. Cuối cùng công ty còn công bố nền tảng kết nối mạng Ethernet Spectrum-X mới, được thiết kế và tối ưu cho các máy chủ và các cụm siêu máy tính AI.

Tham khảo Tomshardware, Engadget

Tổ Quốc