‘Vũ khí’ chip được mệnh danh là phép màu công nghệ, từ SK Hynix đến Samsung đều tranh giành, Nvidia đặc biệt yêu thích

Cuộc cách mạng AI không thể sống thiếu sản phẩm quan trọng này!

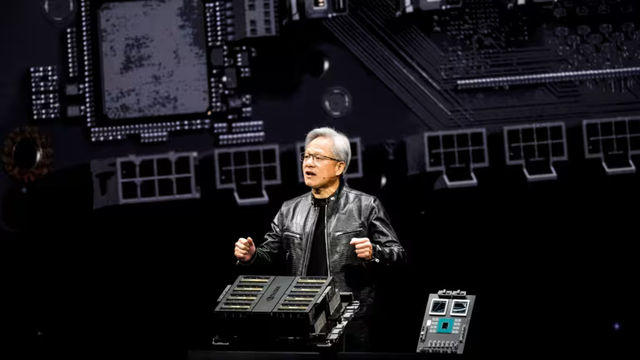

Giám đốc điều hành Nvidia Jensen Huang, trong chiếc áo khoác da đen quen thuộc tại một hội nghị vào tháng 3 tại San Jose, đã không thể che giấu sự phấn khích của mình với chip bộ nhớ băng thông cao (HBM). Ông gọi chúng là ‘phép màu công nghệ’, là một phần thiết yếu của cuộc cách mạng AI.

Gã khổng lồ chip của Mỹ chuyên sản xuất các bộ xử lý đồ họa hỗ trợ ChatGPT và các ứng dụng AI tiên tiến. Để GPU hoạt động hết tiềm năng cần có HBM - thứ mà Nvidia cho đến nay chủ yếu mua từ SK Hynix của Hàn Quốc. Khi nhu cầu về chip AI tăng cao, công ty đang tìm cách mở rộng danh sách các nhà cung cấp của mình và chính điều này đang gây ra màn cạnh tranh khốc liệt giữa các nhà sản xuất chip nhớ.

Hiện tại, SK Hynix là người dẫn đầu với hơn một nửa thị phần toàn cầu cho HBM. Người đồng hương Samsung Electronics và Micron của Mỹ cũng đang chạy đua để bắt kịp, cạnh tranh không chỉ về công nghệ mà còn về giá cả.

HBM, nói một cách đơn giản, là một dạng chip DRAM có cấu trúc xếp chồng. Điều này đồng nghĩa với việc một nhà sản xuất HBM cạnh tranh không chỉ giỏi sản xuất và tìm nguồn cung ứng DRAM mà còn thành thạo các kỹ thuật xếp chồng tiên tiến.

“Sản xuất HBM không dễ dàng. Chỉ một lớp xếp chồng gặp vấn đề, toàn bộ sản phẩm sẽ cần phải loại bỏ. Năng suất là một trong những phần rất thách thức”, một giám đốc điều hành của công ty chip cho biết.

Theo nhà phân tích Avril Wu của TrendForce, bất chấp những thách thức, ba ông lớn vẫn đang cược lớn vào HBM bởi chúng đang được bán với giá gấp khoảng 5 lần DDR5, loại DRAM tiên tiến nhất được sử dụng trong máy tính.

Nhà phân tích ước tính, thị phần của HBM có thể chiếm hơn 20% tổng giá trị thị trường DRAM trong năm nay và tiếp tục tăng lên hơn 30% vào năm 2025 nhờ nhu cầu điện toán AI ngày càng tăng.

SK Hynix tự tin rằng họ có thể tiếp tục dẫn đầu thị trường HBM nhờ công nghệ xếp chồng tiên tiến có tên MR-MUF. “Chúng tôi đã và đang tăng cường sản xuất hàng loạt HBM3e một cách ổn định. ... Chúng tôi bắt đầu áp dụng công nghệ MR-MUF từ HBM2e bốn lớp và đã duy trì khả năng cạnh tranh cao nhất ngành đối với HBM3 và HMB3e tám lớp”, Kim Jong-hwan, phó chủ tịch của công ty, cho biết.

Cách đây 1 thập kỷ, SK Hynix đã phát triển HBM đầu tiên trên thế giới sử dụng trong trò chơi điện tử. Sau sự ra đời của AI tổng quát khiến sản phẩm này càng thêm quan trọng. Phiên bản mới nhất là HBM3e, dự kiến được Nvidia áp dụng vào cuối năm nay.

CEO Nvidia

SK Hynix được dự báo sẽ tiếp tục dẫn đầu mảng HBM vào năm 2024, với thị phần trên 52%, theo dữ liệu của Trendforce. Samsung hiện đang bám riết ở mức 42,4%, trong khi Micron dự kiến kiểm soát hơn 5% thị trường.

“Việc thương mại hóa sản phẩm HBM3e đang diễn ra suôn sẻ theo đúng tiến độ của khách hàng. Chúng tôi hy vọng doanh số bán hàng sẽ được tạo ra sớm nhất là vào cuối quý II”, Kim Jae-june, phó chủ tịch điều hành mảng kinh doanh chip nhớ của Samsung, cho biết trong một cuộc gọi hội nghị vào tháng trước. Phía Samsung không đề cập đến tên khách hàng, song Nvidia đã xác nhận vào tháng 3 rằng họ đang thử nghiệm các mẫu HBM của Samsung.

Tuy nhiên, theo các chuyên gia, sự chênh lệch về trình độ công nghệ giữa SK Hynix và Samsung vẫn sẽ tồn tại trong một thời gian nữa. Shelley Jang, giám đốc Fitch Ratings, cho biết trong một hội nghị vào tháng trước: “Chúng tôi tin rằng sẽ mất một thời gian để Samsung bắt kịp. Đó là do có một số khác biệt về công nghệ. SK Hynix có thể chiếm thế thượng phong và về trung và dài hạn, chúng tôi không nghĩ cấu trúc thị trường bán dẫn sẽ thay đổi mạnh”.

Vào tháng 2, nhà sản xuất chip nhớ Micron của Mỹ tuyên bố đã bắt đầu sản xuất hàng loạt chip HBM3e của riêng mình. Micron cho biết, những sản phẩm này sử dụng ít năng lượng hơn 30% so với các sản phẩm đối thủ và cũng sẽ được Nvidia ứng dụng trong GPU H200.

Sự bùng nổ AI đã mang lại lợi ích cho Micron. Chủ tịch kiêm Giám đốc điều hành Micron Sanjay Mehrotra cho biết: “Chúng tôi đang ở giai đoạn đầu của giai đoạn tăng trưởng kéo dài nhiều năm được thúc đẩy bởi AI. Công nghệ đột phá này sẽ biến đổi mọi khía cạnh của doanh nghiệp và xã hội. HBM của chúng tôi đã bán hết cho năm 2024 và phần lớn nguồn cung cho năm 2025 đã được phân bổ”.

Powertech, nhà cung cấp dịch vụ thử nghiệm và đóng gói chip nhớ hàng đầu thế giới, cho biết họ đang làm việc với một số khách hàng để khám phá các cơ hội trong tương lai. DK Tsai, chủ tịch của Powertech cho biết: “Hiện tại, HBM chủ yếu dành cho điện toán máy chủ trung tâm dữ liệu. Chúng tôi nhận thấy rằng trong tương lai, ngay cả máy tính và thiết bị điện tử tiêu dùng cũng có thể sử dụng HBM”.

Doris Hsu, chủ tịch và giám đốc điều hành của Globalwafers, nhà sản xuất tấm wafer lớn thứ ba thế giới, cho biết HBM đã và đang thay đổi thị trường.

“HBM chắc chắn là một trong những thế lực tăng trưởng quan trọng trong nửa cuối năm nay. Trong tương lai, điều này chắc chắn sẽ thay đổi ngành công nghiệp bộ nhớ DRAM vì nhu cầu đang tăng quá nhanh”.

“Từ góc độ khách hàng, việc phụ thuộc vào một nhà cung cấp duy nhất sẽ là điều đáng lo ngại vì thị trường HBM đang tăng trưởng nhanh chóng. Chúng tôi tin rằng sự cạnh tranh sẽ giúp thị trường bộ nhớ AI phát triển hơn nữa”, Phó chủ tịch SK Hynix Kim Jong-hwan cho biết.

Tuy nhiên, thị trường chip nhớ nổi tiếng là nhạy cảm với những biến động về cung và cầu. Theo nhà phân tích Pak Yu-ak của Kiwoom Securities, nguy cơ dư cung HBM ngay trong năm tới là có thể xảy ra.

“Nếu Samsung Electronics thành công trong việc bán chip HBM3e, thị trường HBM dự kiến sẽ phải đối mặt với tình trạng dư cung vào năm 2025”, ông Pak cho biết trong một báo cáo hồi tháng 3.

Theo: Nikkei Asia

An ninh tiền tệ