Tốn hơn 15 tỷ đồng mỗi ngày để vận hành ChatGPT, Microsoft bí mật tự làm chip AI để giảm chi phí

Không chỉ giảm chi phí, dự án chip AI này còn giúp tham vọng AI ngày càng lớn của Microsoft tránh phải phụ thuộc hoàn toàn vào đối tác Nvidia.

- 23-04-2023Xôn xao thông tin truy cập WiFi miễn phí ở một quốc gia Đông Nam Á có thể bị phạt tới 3 năm tù: Thực hư thế nào?

- 23-04-2023Nhật Bản thử nghiệm sử dụng ChatGPT cho dịch vụ công

- 23-04-2023Nhìn lại những lựa chọn 'cắm cờ' ở nước ngoài của các 'ông lớn' Việt: Vingroup, Viettel và FPT có gì khác nhau?

Theo Dylan Patel, trưởng phân tích tại hãng nghiên cứu bán dẫn SemiAnalysis, việc vận hành ChatGPT sẽ tiêu tốn đến 700.000 USD mỗi ngày. Đó là chi phí cần thiết cho hệ thống hạ tầng để chatbot AI này giúp hàng triệu người trên thế giới viết thư xin việc, lên kế hoạch tập luyện, làm bài tập hoặc chỉnh sửa bài đăng trên mạng xã hội.

Để đáp ứng được các nhu cầu trên, ChatGPT đòi hỏi một lượng tính toán khổng lồ để đưa ra các câu trả lời dựa trên truy vấn của người dùng. Ông Patel cho biết: "Phần lớn chi phí này là vì chúng cần đến các máy chủ đắt đỏ."

Thậm chí đối với mô hình GPT-4 mới ra mắt của OpenAI, chi phí vận hành này còn lớn hơn nữa, khi quy mô dữ liệu của mô hình mới còn lớn hơn nữa, vì vậy sẽ cần có sức mạnh xử lý lớn hơn.

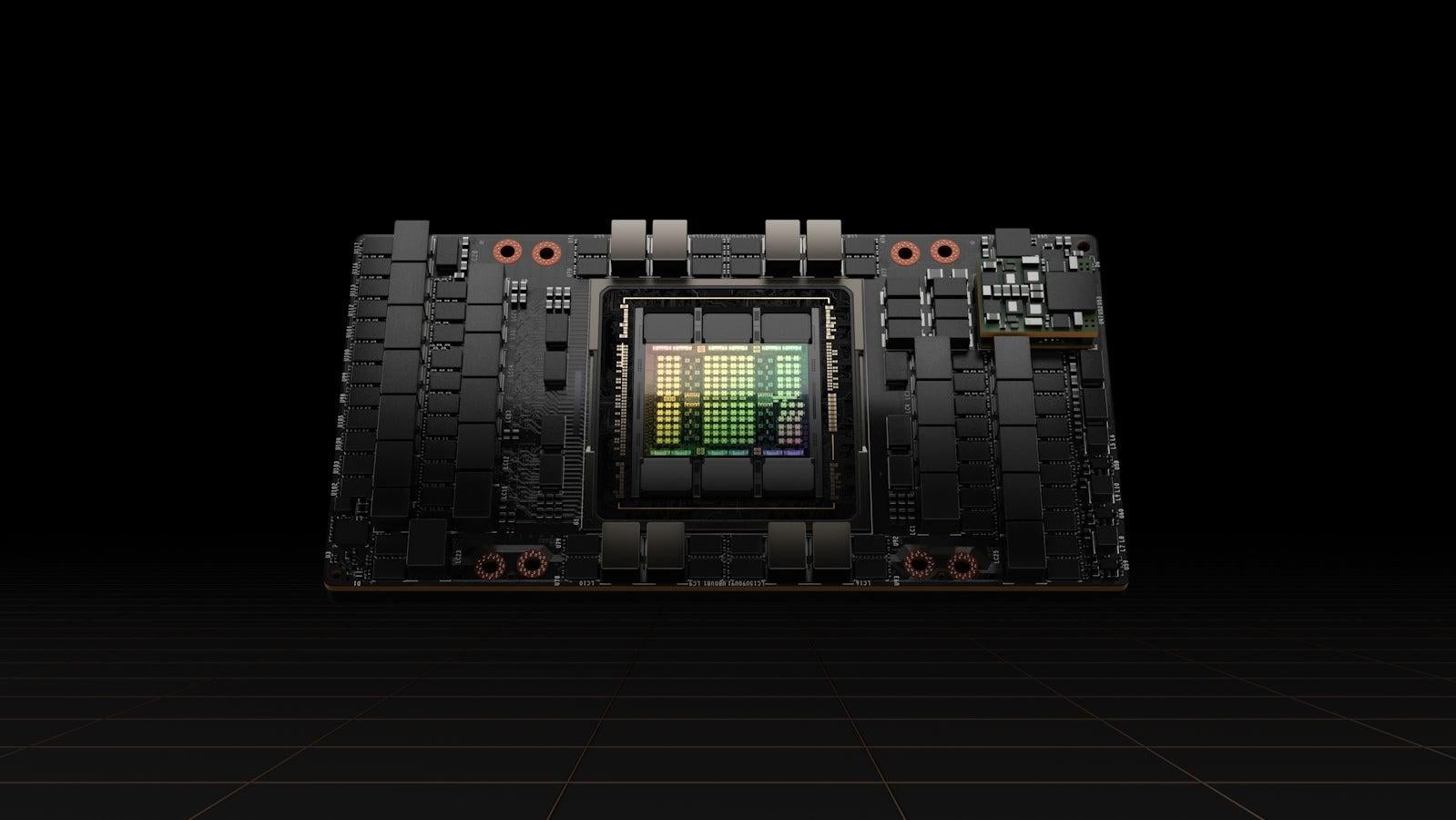

GPU H100 mới của Nvidia, được cho có giá từ 36.000 USD đến 40.000 USD mỗi sản phẩm. Ảnh Internet

Một phần đáng kể chi phí này là do những con chip đồ họa A100 đắt đỏ của Nvidia. Các chip này chiếm đến 90% thị phần GPU trung tâm dữ liệu dành cho việc huấn luyện và vận hành các mô hình AI. Mới đây nhất, Nvidia còn giới thiệu chip H100 với hiệu năng huấn luyện cao gấp 9 lần so với A100.

Tất nhiên cả 2 loại GPU trung tâm dữ liệu này đều có giá thành không hề rẻ. Trong khi chip A100 có giá 10.000 USD mỗi sản phẩm, báo cáo của CNBC cho biết, giá bán của chip H100 còn lên đến mức 40.000 USD khi rao bán trên eBay. Hiệu năng cao cùng với chi phí triển khai các trung tâm dữ liệu AI đắt đỏ là lý do làm cho chi phí vận hành ChatGPT cao đến như vậy.

Chính vì vậy, một báo cáo mới đây của trang The Information với các nguồn tin thân cận cho biết, Microsoft đang tìm cách cắt giảm chi phí cho hạ tầng máy chủ bằng cách tự phát triển một con chip riêng cho các mô hình AI có tên gọi Athena.

Dự án chip Athena này được Microsoft triển khai từ năm 2019 - cùng thời điểm với khoản đầu tư 1 tỷ USD đầu tiên vào OpenAI của công ty. Ảnh Internet

Theo nguồn tin của The Information, dự án chip Athena này đã được Microsoft phát triển từ năm 2019 – cùng thời điểm với khoản đầu tư 1 tỷ USD đầu tiên của Microsoft vào hãng OpenAI, công ty tạo nên ChatGPT và mô hình GPT-4.

Theo báo cáo, con chip này hiện đang được bí mật thử nghiệm trên một nhóm nhỏ nhân viên Microsoft và OpenAI. Con chip này được thiết kế để có thể xử lý cả việc huấn luyện và vận hành các hệ thống AI – tất nhiên trên các máy chủ nội bộ của Microsoft, thay vì máy tính PC trong nhà bạn. Dự kiến, con chip Athena này sẽ được sản xuất trên tiến trình 5nm của TSMC và ra mắt vào đầu năm sau.

Với tham vọng ngày càng lớn của mình đối với các mô hình AI, dễ hiểu vì sao Microsoft cần phải nắm trong tay một công nghệ độc quyền cho riêng mình. Bên cạnh ChatGPT, một chatbot với công nghệ tương tự cũng được tích hợp vào trong ứng dụng Bing của công ty, ngoài ra một chatbot khác cũng được công ty phát triển để đưa vào các ứng dụng kinh doanh khác, bao gồm bộ ứng dụng Microsoft 365 và bản thân Windows 11.

Cho dù Athena không giúp Microsoft loại bỏ hoàn toàn các chip Nvidia, nhưng sẽ giúp công ty tiết kiệm đáng kể chi phí vận hành và huấn luyện AI. Ảnh Internet

Với quy mô ứng dụng chatbot ngày càng được mở rộng, kéo theo là số lượng người dùng đang gia tăng nhanh chóng, chi phí vận hành cũng như xây dựng hạ tầng huấn luyện các mô hình AI đó có thể tăng lên cao gấp nhiều lần so với con số 700.000 USD dành cho ChatGPT hiện nay. Một bộ xử lý dành riêng cho các tác vụ này có thể làm giảm đáng kể chi phí đó cũng như giúp tham vọng của Microsoft không phải phụ thuộc hoàn toàn vào đối tác Nvidia.

Điều này càng quan trọng hơn khi đối thủ của họ, hãng Google cũng mới giới thiệu bộ xử lý AI dành cho các siêu máy tính có tên Tensor Processing Unit. Công ty cho biết, họ có thể kết nối trực tiếp hàng nghìn con chip này với nhau để làm nên một siêu máy tính AI máy học. Hệ thống này đang được sử dụng để huấn luyện mô hình AI của PaLM của công ty, công nghệ nền tảng vận hành chatbot Bard AI hiện nay.

Bên cạnh tăng tốc hiệu năng xử lý máy học AI của hệ thống, Google cho biết, con chip này sử dụng ít năng lượng hơn từ 2 đến 6 lần và thải ra ít CO2 ít hơn 20 lần so với các "bộ tăng tốc xử lý tác vụ đương thời". So với mức chi phí khổng lồ và tiêu tốn năng lượng khủng khiếp để huấn luyện và vận hành các mô hình AI hiện nay, Microsoft chắc chắn sẽ muốn làm được điều tương tự để không bị đối thủ bỏ xa phía sau.

Thể thao và Văn hóa