Đột phá trong khả năng đọc suy nghĩ: Một công cụ AI có thể tái tạo lại hình ảnh con người nhìn thấy

Dùng một mô hình AI đang nổi tiếng hiện nay, các nhà khoa học có thể tái tạo lại hình ảnh con người nhìn thấy bằng cách quét hoạt động não.

- 23-03-2023Do Kwon đã bị bắt?

- 23-03-2023Bí quyết giúp cặp vợ chồng kiếm 200 tỷ mỗi năm nhờ bán hàng online

- 23-03-2023‘Kỳ tích’ digital marketing ngành sữa Việt Nam: Chi tiêu 2 tháng chỉ bằng 1 ngày của hãng lớn nhưng hiệu quả thì thật bất ngờ

Quét não bộ của con người và nhận biết được cách đôi mắt mọi người nhìn thấy thế giới xung quanh như thế nào vốn là mơ ước bao lâu nay của những nhà khoa học thần kinh. Nắm được các hiểu biết này, những nhà khoa học có thể đưa ra các giải pháp cải thiện khả năng giao tiếp của người khuyết tật đối với người khác cũng như thế giới xung quanh.

Giờ đây ước mơ đó đang dần trở thành hiện thực nhờ vào các bước tiến trong công nghệ AI. Vào tháng 10 năm ngoái, các phần mềm AI đã giúp các nhà khoa học quét hình ảnh não và tái tạo thành dạng văn bản, giờ đây các mô hình AI ngôn ngữ tự nhiên còn giúp tái tạo lại cả các hình ảnh mà đôi mắt con người nhìn thấy.

Mô hình AI trợ giúp cho các nhà khoa học lần này đến từ thuật toán của Stable Diffusion, công cụ AI nổi tiếng với khả năng sản sinh ra các hình ảnh từ những lời gợi ý của người dùng – tương tự như các công cụ AI khác ví dụ như Dall-E 2 và Midjourney.

Ảnh Internet

Huấn luyện bằng các dữ liệu văn bản thu được từ quét não

Trong nghiên cứu của mình, dựa vào hệ thống của Stable Diffusion, các nhà thần kinh học của trường Đại học Osaka, Nhật Bản huấn luyện bổ sung cho dữ liệu của nó, liên kết các mô tả bằng văn bản về hàng nghìn bức ảnh do những người tham gia nghiên cứu quét não tạo ra khi họ được quan sát chúng.

Điều đặc biệt ở Stable Diffusion – cũng như các mô hình AI ngôn ngữ lớn hiện nay – là nó có khả năng học tập rất nhanh dù chỉ được đào tạo trên một số ít dữ liệu. Đây là một bước tiến dài đối với quá trình huấn luyện AI khi giúp các nhà nghiên cứu tiết kiệm đáng kể thời gian và công sức cho quá trình này. Bên cạnh đó, nhà thần kinh học Ariel Goldstein cho rằng, đây cũng là một cách tiếp cận mới khi có thể kết hợp cả thông tin bằng văn bản và hình ảnh để "giải mã bộ não".

Để thu thập được phần mô tả bằng văn bản của bộ não đối với hình ảnh mà đôi mắt nhìn thấy, thay vì gắn các điện cực vào não, giờ đây các nhà nghiên cứu sử dụng máy chụp cộng hưởng từ chức năng (fMRI: functional magnetic resonance imaging) để quét và phát hiện các thay đổi trong lưu lượng máu đến các vùng hoạt động của não.

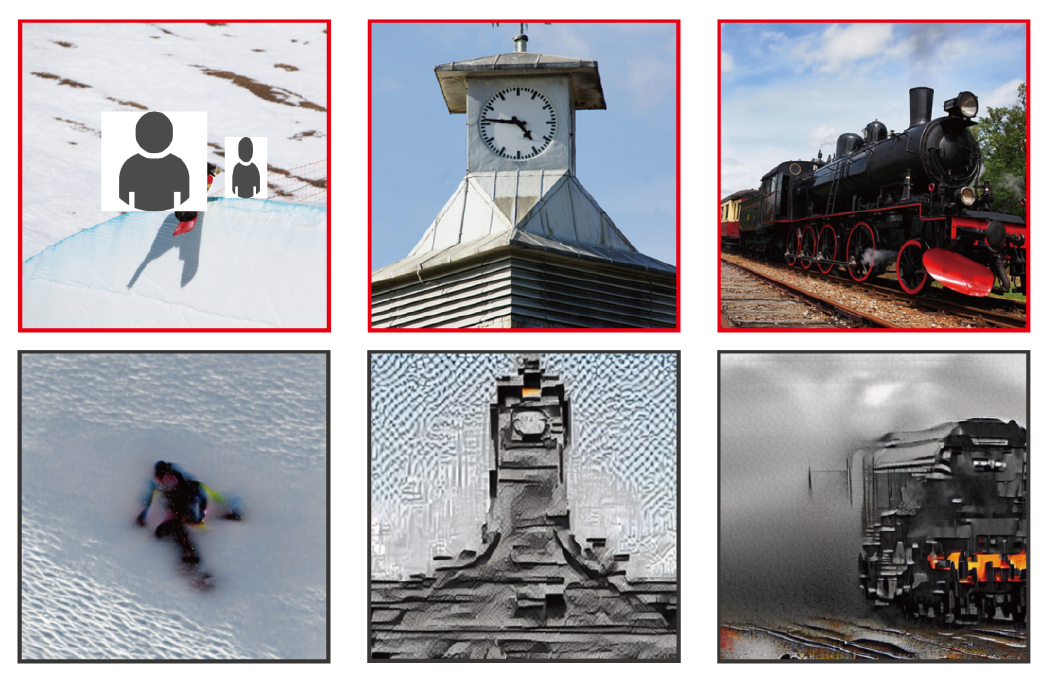

Thuật toán AI của Stable Diffusion có thể tái tạo lại các hình ảnh con người nhìn thấy khi quét não. Ảnh Science

Khi mọi người xem một bức ảnh nào đó, thùy thái dương sẽ đóng vai trò đăng ký thông tin về nội dung bức ảnh (con người, vật thể hay phong cảnh) trong khi thùy chẩm sẽ đóng vai trò đăng ký thông tin về bố cục và phối cảnh, ví dụ tỷ lệ hoặc vị trí của nội dung. Các thông tin này sẽ được máy fMRI ghi lại khi nó theo dõi các hoạt động đỉnh của não.

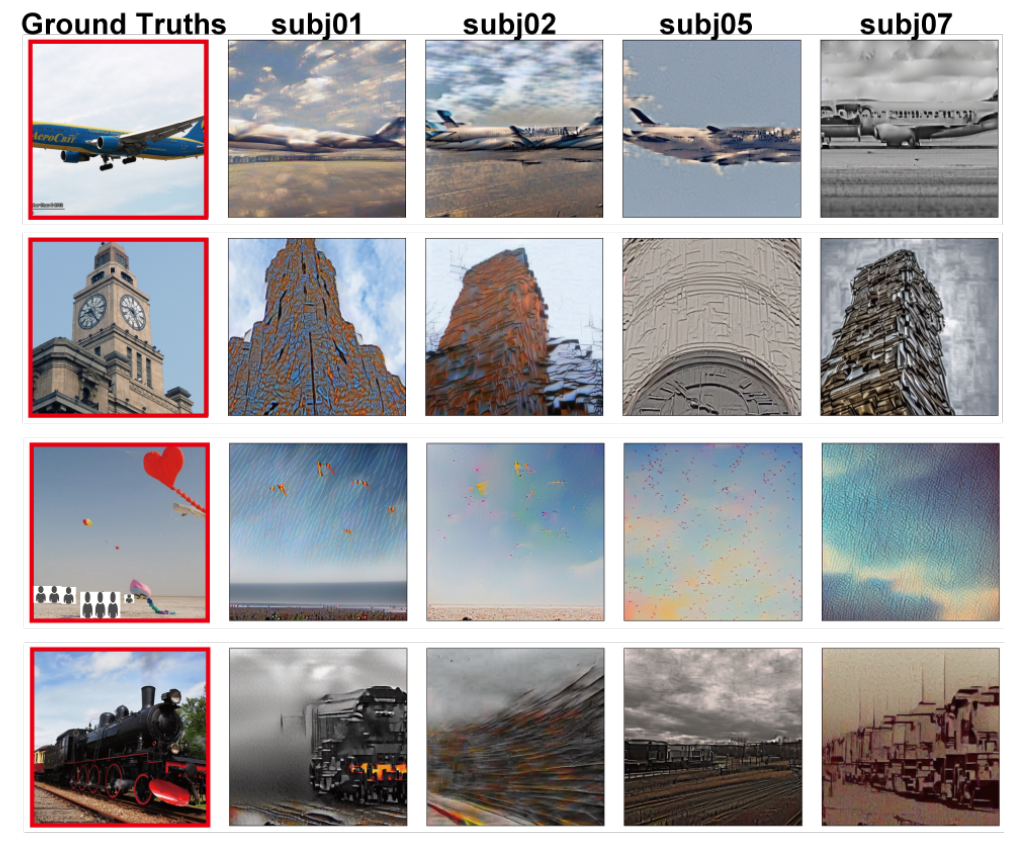

Từ thông tin mô tả bằng văn bản này, thuật toán AI của Stable Diffusion có thể chuyển hóa thành một hình ảnh mô phỏng – tương tự như cách nó đang tạo ra các hình ảnh từ những lời gợi ý của người dùng. Trong nghiên cứu này, các nhà khoa học sử dụng bộ dữ liệu trực tuyến do trường đại học Minnesota cung cấp để huấn luyện cho Stable Diffusion. Bộ dữ liệu này chứa thông tin quét não của 4 người tham gia thí nghiệm, mỗi người được xem 10.000 hình ảnh.

Ngay cả các nhà nghiên cứu cũng phải ngạc nhiên về hiệu quả thu được. Ảnh Science

Ban đầu mỗi hình ảnh do AI tạo ra đều có nhiễu và sau đó chúng được thay thế bằng các đường nét có thể phân biệt được khi thuật toán của Stable Diffusion so sánh hình ảnh vừa tạo ra với các mô hình trong dữ liệu huấn luyện của nó. Nhờ vậy, hệ thống này có thể tạo ra một hình ảnh miêu tả gần đúng nội dung, bố cục và phối cảnh của hình ảnh mà người tham gia thí nghiệm đã xem.

Tuy nhiên, các nhà nghiên cứu nhận thấy thuật toán lại gặp khó khăn trong việc nhận biết đối tượng trong ảnh, ví dụ, nó không tạo ra được hình ảnh tháp đồng hồ như trong bức ảnh, thay vào đó nó tạo ra các hình dáng được trừu tượng hóa. Vấn đề này có thể được giải quyết bằng cách sử dụng các bộ dữ liệu huấn luyện lớn hơn, tuy nhiên, các nhà nghiên cứu Nhật Bản cho biết dữ liệu từ máy fMRI quá hạn chế so với yêu cầu này.

Thay vào đó, các nhà nghiên cứu giải quyết thách thức này bằng cách bổ sung thêm các từ khóa trong phần chú thích về hình ảnh trong bộ dữ liệu fMRI của trường Minnesota. Ví dụ nếu trong một bức ảnh có chứa tháp đồng hồ, phần thông tin quét não sẽ được liên kết với đối tượng đó và sau đó dữ liệu này sẽ được nạp vào hệ thống huấn luyện của Stable Diffusion.

Độ chính xác của hình ảnh tái tạo được tăng dần sau mỗi lần tinh chỉnh. Ảnh Science

Điều quan trọng hơn là thuật toán của Stable Diffusion không trực tiếp tạo ra hình ảnh từ lời nhắc trong dữ liệu văn bản – nó chỉ có thể nhận ra sự xuất hiện của đối tượng trong hình ảnh nếu mô hình hoạt động của não khớp với mẫu mô hình trong dữ liệu huấn luyện. Do vậy, thuật toán mới chỉ tái tạo lại các đối tượng xuất hiện trong những hình ảnh huấn luyện, thay vì các hình ảnh mới.

Để vượt qua thách thức này, những người tham gia thí nghiệm được quét não bổ sung khi xem các hình ảnh riêng biệt về đồng hồ, gấu đồ chơi, máy bay và tàu hỏa. Bằng cách so sánh các dữ liệu quét riêng biệt đó với mẫu hình ảnh xuất hiện trong bộ dữ liệu huấn luyện, thuật toán AI có thể tạo ra những hình ảnh chính xác hơn, thuyết phục hơn ngay cả khi gặp phải các hình ảnh mới. Kết quả thu được từ phương pháp này thật sự ấn tượng.

Tuy nhiên, hiện tại hệ thống mới chỉ thử nghiệm với dữ liệu quét não của 4 người tham gia thí nghiệm, do vậy, để nhận diện được hình ảnh của mà những người khác nhìn thấy, hệ thống này cần phải được huấn luyện lại. Vì vậy sẽ phải mất thêm một thời gian nữa để hệ thống này có thể được áp dụng phổ biến.

Khi công nghệ này được phát triển đến mức độ cao hơn, các nhà nghiên cứu kỳ vọng rằng có thể ứng dụng nó vào việc khám phá cách các loài vật nhận thức về thế giới và thậm chí một ngày nào đó có thể ghi lại cả giấc mơ của con người cũng như hỗ trợ giao tiếp với người bị liệt.

Tham khảo Science

Thể thao & Văn hóa